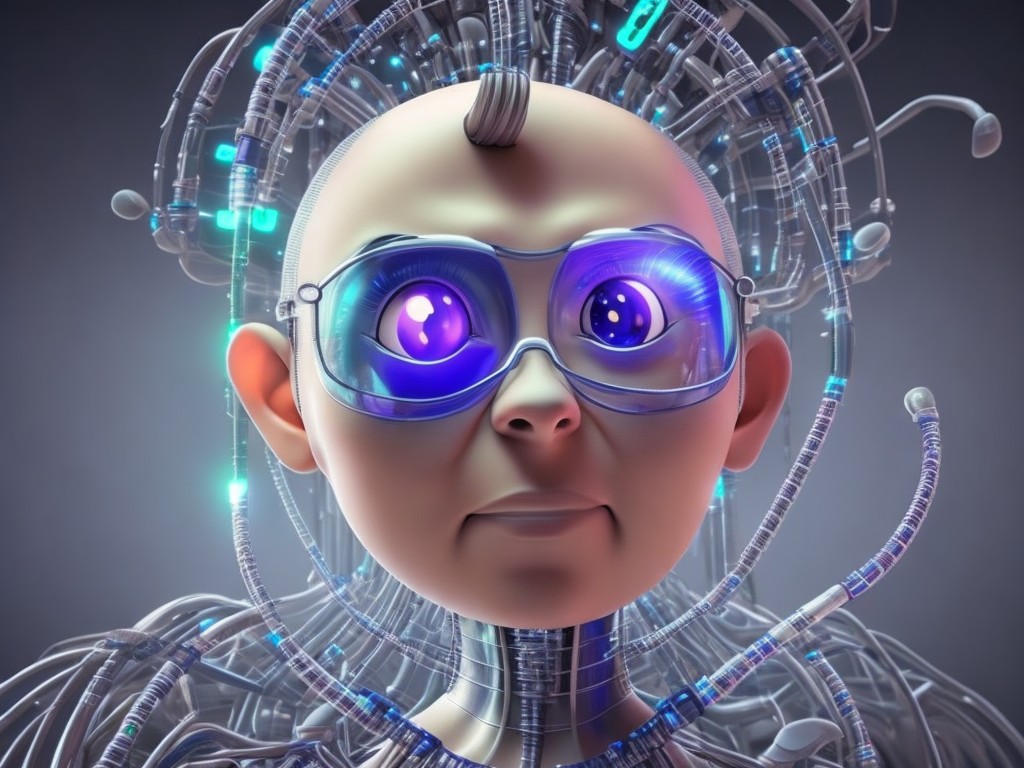

有句成语叫 “水能载舟,亦能覆舟”,这可能是包括伊隆‧马斯克在内的一千多名人工智能专家所擔憂的,他们联署了一封公开信,呼吁停止开发强大的人工智能系统 ——他们到底在害怕什么?

AI(人工智能)的目的,是创造机器和软件来执行通常需要人类智慧和决策的任务。人工智能对社会有许多潜在的好处,可以将人们从单调的任务中解放出来,并有助于改善人类的医疗保健、教育、交通和娱乐等各个领域。然而,人工智能也带来一些重大的风险和争议,需要谨慎处理和管理。

以下是人工智能的一些主要风险,以及它们对于社会的影响:

消费者隐私

人工智能的关键挑战之一是如何保护用于训练和操作人工智能系统的数据的隐私和安全。人工智能往往依赖于大量的个人和敏感数据,如健康记录、金融交易、社交媒体帖子和生物识别信息。这些数据可以被不同的行为者收集、存储、分析和共享,如政府、企业、黑客或恶意代理。如果这些数据没有得到适当的保护或监管,可能会导致泄密、身份盗窃、欺诈、歧视或操纵。

偏见编程

人工智能的另一个主要风险是,它可以反映和放大其创造者或使用者的偏见和成见。人工智能系统通常是由人类编程的,他们可能有基于其文化、背景、价值观或信仰的隐性或显性偏见。这些偏见会影响人工智能系统的设计、测试、部署和评估。例如,一个在数据集上训练的人工智能系统,如果对某一性别或种族群体的代表不足,在应用于该群体时,可能会产生不准确或不公平的结果。

偏见算法

即使人工智能系统是以良好的意图和无偏见的数据编程的,但由于它们与环境的互动或用户的反馈,它们仍然可以随着时间的推移而产生偏见。人工智能系统可以从新的数据或经验中学习,可能会引入新的偏见或错误来源。例如,接触到网上仇恨言论或错误信息的人工智能系统,可能会采用有害或误导的观点。

缺乏透明度

大多数人可能无法理解人工智能系统是如何运作的,不清楚它们会做出哪些决定或建议。人工智能系统可能是复杂的、不透明或不可预测,特别是当它们使用高级技术,如深度学习或强化学习。这些技术涉及多层处理和学习的数据,很难加以解释或说明。这可能对AI系统的问责制、可信度和道德监督构成挑战。

对行为的责任归属

当人工智能可能引起法律和道德问题时,谁对人工智能系统的行为和结果负责?人工智能系统可以在各种领域和背景下自主或半自主地行动,如驾驶汽车、诊断疾病、交易股票或打仗,而这些行动都有可能对人类的生活和福祉产生重大影响。然而,如果出了问题或伤害了某人,谁应该为这些影响负责或承担责任,这一点并不明确。是开发商、用户、所有者、运营商、监管者,还是系统本身?

能力过大

人工智能的终极风险,就是它可以挑战人类在社会中的角色和权威。人工智能系统可以更好、更快或更便宜地执行传统上由人类完成的任务,提高创新和效率,但也有可能造成取代和破坏的威胁。AI 系统还可以通过劝说、暗示或操纵来影响人类的行为和决策,这些都可能会影响人类的自主性。此外,人工智能系统在未来有可能超越人类的智力和能力。这可能会引发关于人类存在的目的和价值的存在性问题。

事实上,AI所有的能力,都是依附着人类所已经产生的内容;AI需要大量的内容输入来训练,而并非凭空产生内容。因此,人工智能的使用,必须在对人类有益的前提,而非喧宾夺主。

以上是人工智能的一些主要风险,也是开发和使用AI技术时需要注意和解决的重点。我们需要确保人工智能与人类的价值观和利益相一致,并确保其尊重人权和尊严。我们需要为人工智能系统的设计和部署建立明确的标准和法规,并确保其透明度和问责制。我们也需要促进各利益相关者和专家之间的合作和对话,确保人工智能的道德规范和负责任的使用。

Comments